Desde que ChatGPT se introdujo en el mercado, ha habido una gran demanda por parte de los usuarios para experimentar con este tipo de sistemas de inteligencia artificial generativa. Una de las formas más populares de hacerlo ha sido a través de extensiones de navegador.

Robo de datos por extensiones

Sin embargo, a pesar de las diversas opciones que ofrecen, estas extensiones también representan una amenaza para la seguridad de nuestros equipos.

En particular, los expertos en ciberseguridad de Kolide han llevado a cabo un estudio que revela los peligros asociados con esta nueva ola de extensiones de IA. Han descubierto que muchas de ellas están diseñadas con el propósito directo de robar nuestros datos, algo que desafortunadamente no es algo nuevo en el panorama de la seguridad.

Además, algunas de estas extensiones han sido desarrolladas apresuradamente y presentan políticas de privacidad que parecen ser una simple copia y pega de otros servicios. Por supuesto, también existen experimentos de IA desarrollados por empresas conocidas y respetadas.

Evitar el uso de datos sensibles o privados es fundamental. El problema radica en que usuarios de todo el mundo instalan estas extensiones con el propósito de experimentar con sus funciones, y al hacerlo, suelen ingresar datos sensibles que podrían terminar en manos equivocadas.

Este riesgo es especialmente preocupante para los usuarios profesionales que utilizan estas extensiones en sus entornos laborales. El robo de datos por parte de las extensiones es una realidad. En marzo, la empresa de protección de identidad digital, Guardio, informó sobre uno de los primeros casos descubiertos.

Extensiones que comprometen la seguridad

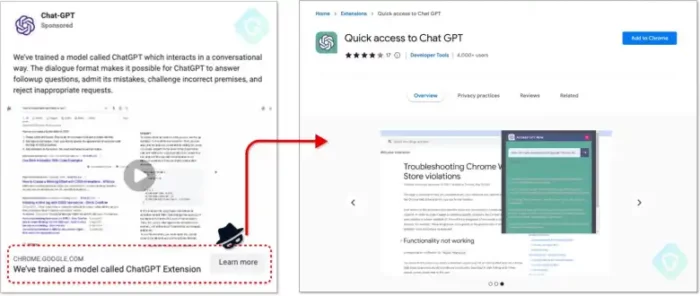

Se trató de una extensión de Chrome llamada “Quick access to Chat GPT” que estaba comprometiendo las cuentas de Facebook de los usuarios y obteniendo una lista de todas las cookies almacenadas en el navegador, incluyendo aquellas relacionadas con los tokens de seguridad.

Google se encuentra desbordado por la situación. Aunque la empresa logró detectar y eliminar una de estas extensiones en apenas una semana, el daño ya estaba hecho: 2.000 usuarios al día la habían descargado y utilizado. Esto mismo ocurrió con numerosas extensiones que prometían, por ejemplo, acceder a ChatGPT directamente desde el navegador.

Además, algo similar ocurre en los dispositivos móviles, donde los usuarios incluso llegan a pagar por el uso de este tipo de herramientas. Existen múltiples amenazas en cuanto a la seguridad. No solo se trata del robo de datos sensibles, sino que incluso las extensiones oficiales pueden presentar problemas de seguridad, como fue el caso de un fallo detectado en la propia plataforma de OpenAI.

Asimismo, surge el problema de los derechos de autor, ya que los textos, códigos o imágenes generados pueden llegar a ser reproducciones parciales de obras protegidas por derechos de autor, lo que plantea importantes cuestiones legales. Incluso los moderadores de Stack Overflow han llegado a declararse en huelga debido a la inundación del sitio con código generado por IA.

Inyección de prompts para fines maliciosos

El funcionamiento de ChatGPT ha dado lugar a otro tipo de ciberataques conocidos como “inyección de prompts”. La idea es simple: intentar lograr que el modelo de IA realice acciones indebidas mediante la introducción de un prompt específico.

Esto fue evidente cuando Microsoft Edge reveló involuntariamente sus “leyes de la robótica”. Sin embargo, los ataques que pueden surgir utilizando este método pueden ser mucho más peligrosos. En mayo, un desarrollador llamado Simon Willison señaló cómo la combinación de complementos de ChatGPT Plus podría utilizarse para extraer datos privados.

Cómo prevenirlo. El funcionamiento actual de los LLMs los hace vulnerables a este tipo de ataques, y según los expertos de Kolide, no parece haber una solución a corto plazo. De hecho, explican que la única forma de protegernos es no facilitarles las cosas a estas extensiones (o al propio ChatGPT): no debemos ingresar datos privados en estas plataformas ni conectarlas a fuentes de datos privados.

No es recomendable, por ejemplo, proporcionar información financiera a ChatGPT con el fin de obtener consejos financieros, ni tampoco buscar un diagnóstico médico preliminar proporcionando síntomas o datos clínicos privados y reales como referencia.

¿Cuál debe ser la respuesta de las empresas? Algunas compañías ya han comprendido claramente que ChatGPT no sabe guardar secretos, y esto incluye información confidencial. Por lo tanto, están prohibiendo el acceso a ChatGPT directamente para sus empleados o limitándolo de manera significativa.

El consejo general para todas estas empresas es que, como mínimo, eduquen y capaciten a sus empleados sobre el uso de estas extensiones y los riesgos asociados. Además, se recomienda implementar “listas blancas” de extensiones verificadas que pueden ser utilizadas.