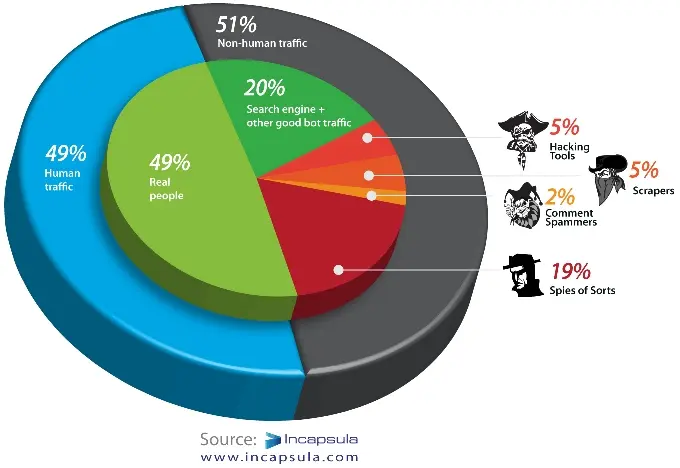

Si estás leyedo (o interpretando) este artículo, existe una posibilidad por cada dos de que seas un robot. De acuerdo a Incapsula, una empresa de seguridad en la red, las personas de carne y hueso representan tan sólo el 49% del total del tráfico web. El 51% restante se divide entre bots “amigables” de indexamiento y análisis de información (19%) y el 31% restante tiene objetivos malignos: desde ataques DDoS hasta spammers.

Curiosamente, herramientas como Google Analytics solamente te muestran la actividad originada por seres humanos (o al menos esa es la idea). Eso quiere decir que de la cantidad de visitas que está marcando este servicio en tu página web, la cantidad real de visitas suele ser mucho más elevada simplemente a causa de estos sistemas automatizados que no siempre pasan por tu página a ofrecerte limonada.

Si comparamos esta cifra con el tráfico de correo electrónico, en el cual el 90% de los emails es considerado spam, yo diría que en el caso web estamos corriendo con un poco más de suerte, aunque es mucho más fácil enviar correos electrónicos basura que rastrear páginas web.

El rastreo automatizado o uso de bots es esencial para el buen funcionamiento de muchos sitios. Aún así, el reto de las empresas de seguridad y monitoreo de sitios consiste en reducir la cifra de bots malignos o al menos limitar el daño que pudieran ocasionar a sitios legítimos.