Microsoft ha presentado una nueva serie de modelos de IA ligeros, de código abierto, y que según afirma, superan a Gemini 1.5 Flash de Google, Llama 3.1 de Meta y GPT-4o de OpenAI en algunos aspectos.

Tres nuevos modelos de lenguaje

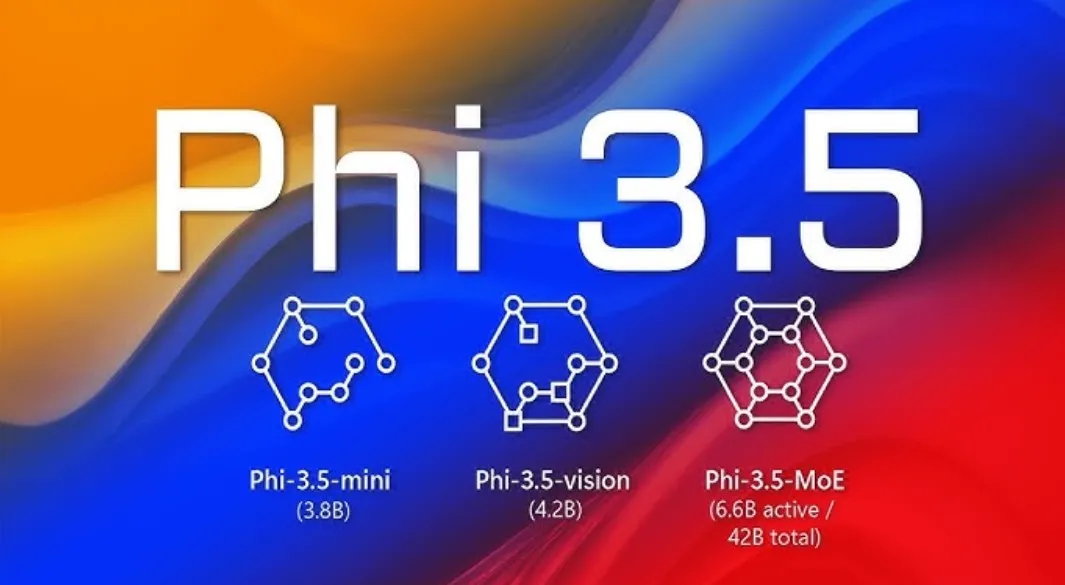

Phi-3.5-mini-instruct, Phi-3.5-Mixture of Experts (MoE)-instruct y Phi-3.5-vision-instruct son las últimas adiciones a la familia de modelos de lenguaje pequeños (SLMs) de la compañía tecnológica, conocidos como la serie Phi-3. El primer SLM de Microsoft, Phi-3-mini, hizo su debut en abril de este año.

En primer lugar, Phi-3.5-mini-instruct cuenta con 3.82 mil millones de parámetros, mientras que el Phi-3.5-MoE-instruct tiene 41.9 mil millones de parámetros, pero solo opera con 6.6 mil millones de parámetros activos. Por su parte, el Phi-3.5-vision-instruct incluye 4.15 mil millones de parámetros.

El número de parámetros de un modelo de IA es un indicador de su tamaño y proporciona una estimación del conocimiento y las habilidades que posee a través del aprendizaje automático.

Entrenamiento en tiempo récord

Los tres modelos Phi 3.5 admiten una ventana de contexto de 128k tokens. Las ventanas de contexto se miden en tokens y señalan la cantidad de información que un modelo de IA puede procesar y generar en un momento dado.

Las ventanas de contexto más largas significan que el modelo es capaz de procesar más texto, imágenes, audio, código, video, etc.

Según Microsoft, el Phi-3.5 Mini se entrenó durante diez días con 3.4 billones de tokens, mientras que el Phi-3.5 MoE se entrenó durante 23 días con 4.9 billones de tokens.

Este modelo requirió 500 mil millones de tokens y seis días de entrenamiento. Los conjuntos de datos de entrenamiento utilizados para los nuevos modelos Phi-3.5 consistían en datos de alta calidad, ricos en razonamiento y disponibles públicamente.

Capacidad de procesar texto e imágenes

El Phi-3.5 Mini está equipado con capacidades de razonamiento básicas y rápidas, útiles para generar código o resolver problemas matemáticos y lógicos. Al ser una combinación de múltiples modelos especializados en ciertas tareas, el Phi-3.5 MoE puede manejar tareas complejas de IA en múltiples idiomas.

Por otro lado, el Phi-3.5 Vision es capaz de procesar tanto texto como imágenes. Como resultado, el modelo de IA multimodal puede realizar tareas visuales como resumir videos o analizar gráficos y tablas.

Los desarrolladores pueden descargar, personalizar e integrar la serie Phi-3.5 en sus plataformas sin costo, ya que Microsoft ha lanzado estos modelos de IA bajo una licencia de código abierto.

Se puede acceder a ellos a través de Hugging Face, una plataforma de alojamiento en la nube de IA sin restricciones para su uso comercial y modificaciones.

Fuente: HypeRight