Los últimos modelos de OpenAI han incrementado “significativamente” el riesgo de que la inteligencia artificial sea mal utilizada para crear armas biológicas, según reconoció la compañía.

El grupo, con sede en San Francisco, presentó el jueves sus nuevos modelos, denominados o1, destacando sus avanzadas capacidades para razonar, resolver complejos problemas matemáticos y responder a preguntas de investigación científica. Estos avances son vistos como un paso crucial hacia la creación de inteligencia artificial general (AGI), es decir, máquinas con capacidades cognitivas a nivel humano.

Los peligros del nuevo modelo o1

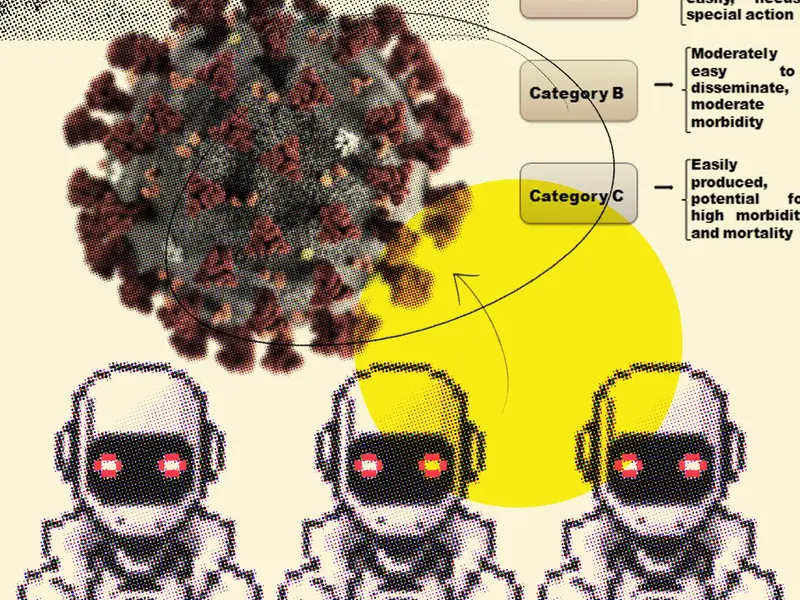

En su tarjeta de sistema, un recurso diseñado para explicar el funcionamiento de la IA, OpenAI señaló que sus nuevos modelos presentan un “riesgo medio” en cuestiones relacionadas con armas químicas, biológicas, radiológicas y nucleares (CBRN), el nivel de riesgo más alto que la empresa ha otorgado a uno de sus sistemas.

La compañía afirmó que estas mejoras han incrementado considerablemente la capacidad de expertos para desarrollar armas biológicas.

Los expertos advierten que el software de inteligencia artificial, con habilidades avanzadas como el razonamiento paso a paso, representa un riesgo elevado si cae en manos de actores malintencionados.

Es necesaria una regulación de desarrollo

Yoshua Bengio, profesor de informática en la Universidad de Montreal y una de las principales autoridades en inteligencia artificial, subrayó que, si OpenAI califica sus modelos con un “riesgo medio” en cuanto a armas químicas y biológicas, esto refuerza la importancia y urgencia de legislar sobre el tema.

Un ejemplo es el proyecto de ley en California, conocido como SB 1047, que busca regular el sector. Esta medida exigiría a los desarrolladores de los modelos más avanzados tomar medidas para minimizar el riesgo de que sus sistemas sean utilizados para crear armas biológicas.

Bengio advirtió que a medida que los modelos de IA avanzan hacia AGI, “los riesgos seguirán aumentando si no se implementan las salvaguardas adecuadas”. Además, destacó que la mejora en la capacidad de la IA para razonar y engañar representa un peligro particular.

Estas advertencias surgen en un contexto donde grandes empresas tecnológicas como Google, Meta y Anthropic compiten por desarrollar sistemas de inteligencia artificial cada vez más sofisticados, con el objetivo de crear software que actúe como “agentes” que asistan a los humanos en diversas tareas y en su vida cotidiana.

OpenAI sabe el potencial que tiene este nuevo modelo

Estos agentes de IA también se perfilan como una fuente de ingresos potencial para las empresas, que enfrentan altos costos para entrenar y operar estos nuevos modelos.

Mira Murati, directora de tecnología de OpenAI, declaró al Financial Times que la compañía está siendo particularmente “cautelosa” con el lanzamiento de o1 debido a sus capacidades avanzadas. Sin embargo, el modelo estará disponible para los suscriptores de pago de ChatGPT y para programadores a través de una API.

Murati añadió que el modelo ha sido probado por expertos en diversas áreas científicas, conocidos como red-teamers, quienes han intentado llevar al límite las capacidades del sistema. Según Murati, los nuevos modelos han demostrado un desempeño notablemente mejor en métricas de seguridad en comparación con versiones anteriores.

OpenAI destacó que el modelo de prueba es seguro para su implementación bajo sus propias políticas y ha sido calificado como de ‘riesgo medio’ en su escala de precaución, ya que no aumenta los riesgos más allá de lo que ya es posible con los recursos existentes.

Fuente: NewsWeek