El viernes pasado Meta anunció el lanzamiento de una serie de innovadores modelos de inteligencia artificial desarrollados por su división de investigación, Fundamental AI Research (FAIR).

Entre estas novedades destaca el Self-Taught Evaluator, un modelo que promete reducir la intervención humana en el proceso de desarrollo de IA. También se presentó un modelo que combina de manera fluida texto y voz.

Nuevas herramientas especializadas en IA

Estas actualizaciones llegan tras la publicación de un documento en agosto, donde Meta expuso que sus nuevos modelos utilizarán el mecanismo de “cadena de pensamiento”, similar a lo que OpenAI ha implementado en sus recientes modelos o1, los cuales procesan información antes de generar respuestas.

Es importante señalar que tanto Google como Anthropic también han investigado el concepto de Reinforcement Learning from AI Feedback, aunque aún no han hecho públicos sus hallazgos.

El equipo de investigadores de IA de FAIR en Meta señaló que estos nuevos lanzamientos respaldan la meta de la compañía de alcanzar una inteligencia de máquina avanzada, promoviendo al mismo tiempo la ciencia abierta y la reproducibilidad.

Los modelos recientemente anunciados incluyen una actualización del Segment Anything Model 2 para imágenes y videos, así como Meta Spirit LM, Layer Skip, SALSA, Meta Lingua, OMat24, MEXMA, y el mencionado Self-Taught Evaluator.

Self-Taught Evaluator: Una Innovación en Modelos de Recompensa

El Self-Taught Evaluator es presentado por Meta como un modelo de recompensa generativa fuerte con datos sintéticos, diseñado para validar el trabajo de otros modelos de IA. La empresa sostiene que este enfoque innovador permite generar datos de preferencia para entrenar modelos de recompensa sin depender de anotaciones humanas.

En esencia, el Self-Taught Evaluator crea sus propios datos para entrenar modelos de recompensa, eliminando la necesidad de que humanos etiqueten la información. Meta afirma que el modelo genera diversas salidas de otros modelos de IA y luego utiliza otro sistema de IA para evaluar y mejorar esos resultados en un proceso iterativo.

Según la compañía, este modelo es más potente y eficiente que aquellos que dependen de datos etiquetados por humanos, como GPT-4 y otros modelos similares.

Meta Spirit LM: Integración Natural de Texto y Voz

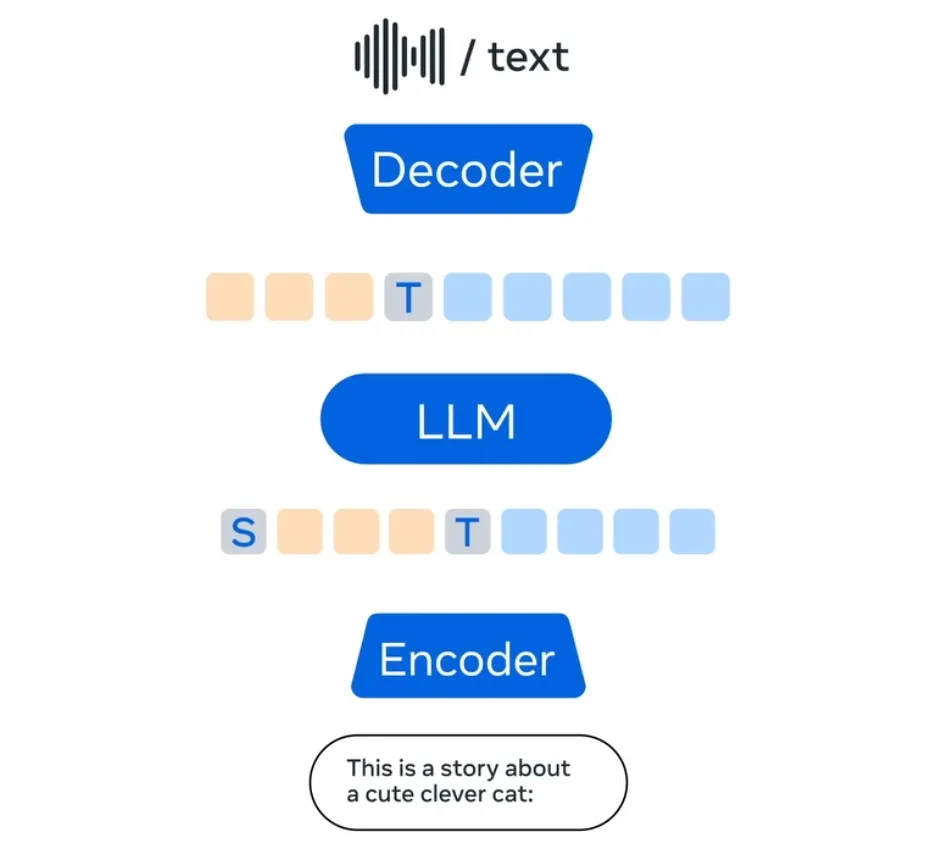

El Meta Spirit LM es un modelo de lenguaje de código abierto diseñado para la integración fluida entre voz y texto. Los modelos de lenguaje grandes suelen ser utilizados para desarrollar sistemas que convierten voz a texto y viceversa.

Sin embargo, este proceso puede hacer que se pierda la expresividad natural del discurso original. Con el Spirit LM, Meta ha creado su primer modelo de código abierto que interactúa con texto y voz de manera más auténtica.

Este modelo se entrena con datos de texto y voz, lo que permite una transición sin esfuerzo entre ambos. Meta ha desarrollado dos versiones del modelo: Spirit LM Base, que se enfoca en los sonidos del habla, y Spirit LM, que captura el tono y la emoción del discurso, como la ira o la emoción, para que suene más realista.

Según Meta, este modelo puede generar un habla más natural y también aprende a realizar tareas como el reconocimiento de voz, la conversión de texto a voz y la clasificación de diferentes tipos de habla.

Fuente: Meta