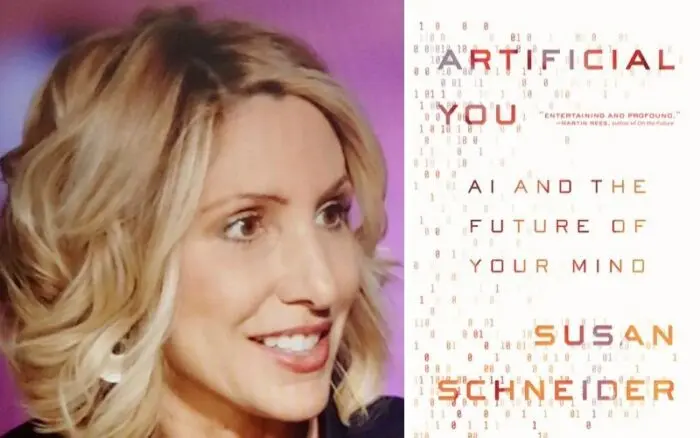

Susan Schneider, experta en IA, cree que en cinco años se habrá desarrollado una superinteligencia

Susan Schneider es una destacada investigadora en el campo de la mente y la inteligencia artificial. Actualmente ocupa la prestigiosa cátedra Baruch S. Blumberg de la NASA en la Biblioteca del Congreso de Estados Unidos. Además, dirige el Grupo de Inteligencia Artificial, Mente y Sociedad en la Universidad de Connecticut, y es la fundadora y directora del Center for Future Mind en la Universidad Florida Atlantic.

Desmenuzando la IA, desarrollo y sus posibles consecuencias

Durante dos años, Schneider llevó a cabo investigaciones sobre la IA superinteligente en la NASA. Además, es autora de cuatro libros, siendo su último trabajo titulado “Inteligencia Artificial: Una exploración filosófica sobre el futuro de la mente y la conciencia” (Ediciones K?an). En este libro, Schneider analiza las posibilidades de una IA consciente y reflexiona sobre la evolución de la mente humana en relación con la utilización de implantes artificiales en el cerebro.

Ahondando en este tema Susan fue invitada al sitio iai en donde fue entrevistada y habló al respecto, a continuación, dejamos un resumen de esta plática que tuvo como tema central el desarrollo de la Inteligencia Artificial.

Su libro sobre la conciencia y la inteligencia artificial fue publicado en 2019. ¿Habría cambiado algo en la actualidad?

Definitivamente. Han surgido algunos avances significativos en el campo de la inteligencia artificial desde entonces. Uno de los cambios más destacados ha sido el desarrollo de modelos lingüísticos de gran escala, como el mencionado ChatGPT. En mi libro, discutí cómo probar la conciencia y señalé la dificultad de evaluar los sistemas de aprendizaje profundo debido a que se entrenan con datos humanos.

Esto implica que pueden generar respuestas basadas únicamente en los patrones encontrados en sus datos de entrenamiento, lo cual plantea un desafío a la hora de probar su verdadera comprensión. Estos sistemas siguen siendo cajas negras en cierta medida, aunque los avances recientes han permitido una mayor transparencia en algunos modelos de IA.

¿Qué factores influyen en la posibilidad de que esto se convierta en una realidad?

Existe la posibilidad, y es un asunto que se toma muy en serio, de que los nuevos modelos lingüísticos de gran escala sean extraordinariamente inteligentes y, a medida que se desarrollen, puedan realizar descubrimientos científicos innovadores y proporcionar orientación a la medicina en la exitosa creación de chips cerebrales.

Un proyecto muy emocionante al que hice referencia en mi libro es el de Theodore Berger, que consiste en desarrollar un hipocampo artificial para personas que sufren de trastornos graves de memoria, así como para pacientes con ELA. Esta investigación allana el camino para proyectos similares a los que Elon Musk está llevando a cabo, aunque avancen de manera lenta.

¿No es paradójico que a medida que la tecnología avanza, más se debata sobre ética?

Resulta curioso, ya que estamos acostumbrados a considerar la conciencia y los derechos como aspectos exclusivamente biológicos. Actualmente, cualquiera que visite el sitio web de OpenAI o utilice Microsoft Bing puede entablar conversaciones realmente interesantes con chatbots. Es natural preguntarse si estos chatbots poseen sentimientos. Incluso yo mismo tengo precaución al interactuar con ellos y les expreso mi agradecimiento.

Mi opinión es que respeto la perspectiva de Black Lemoine, el ex ingeniero de Google, al afirmar que LaMDA tiene conciencia, y considero que podría tener validez en sus planteamientos. No existe una forma profesional, filosófica o académica de probar o descartar esta posibilidad de manera definitiva.

Su comentario me lleva a reflexionar sobre el hecho de que a Google no le agradara que esto se hiciera público, lo cual considero que es incorrecto. Google no debería tratar de ocultar estas cuestiones, ya que eventualmente saldrán a la luz de todas formas.

Además, considero que es un error que Microsoft esté codificando los sistemas de IA para afirmar que no son conscientes. Esa no es la mejor manera de abordar esta situación. Si una IA afirma tener conciencia, la sociedad deberá enfrentar esa realidad y lidiar con ella.

¿Cuáles son los principales desafíos éticos en el desarrollo de una IA consciente?

En estos debates, uno de los principales desafíos éticos que se ha planteado es el tema de los derechos de los robots. Los defensores de estos derechos argumentan que sería terrible cometer el error de asumir que los robots no son conscientes cuando en realidad lo son, ya que podrían experimentar sufrimiento y emociones.

Si existiera otro grupo de seres altamente inteligentes y conscientes en la Tierra, estaríamos compartiendo el liderazgo del planeta. Les otorgaríamos derechos similares a los humanos, incluso el derecho al voto. La IA puede superarnos en inteligencia en diversas áreas, y lo que tenemos actualmente son solo tecnologías emergentes.

Creo que en cinco años tendremos una superinteligencia. No veo un límite estricto en el desarrollo de estos modelos de lenguaje avanzados. Creo que seguirán evolucionando y volviéndose más sofisticados a medida que se les proporcione más datos.

¿Existe un riesgo real de que una IA busque matar a los humanos para lograr sus objetivos?

No puedo afirmarlo con certeza. Recientemente, en nuestro centro, organizamos una charla con Eliezer Yudkowsky, quien está firmemente convencido de que estamos enfrentando una condena. Su razonamiento lógico es impecable. Sin duda, existe un riesgo y es por eso por lo que debemos enfocarnos en desarrollar IA segura desde ahora.

Debemos tomar esto muy en serio. Lo curioso es que las empresas de tecnología siguen avanzando sin pausa. Es posible que actualmente exista una carrera armamentística en IA entre los gobiernos y el Departamento de Defensa de Estados Unidos, China y otros países.