IA ligera y potente, Microsoft presenta la familia Phi-3

Microsoft apuesta por IA pequeña y eficiente

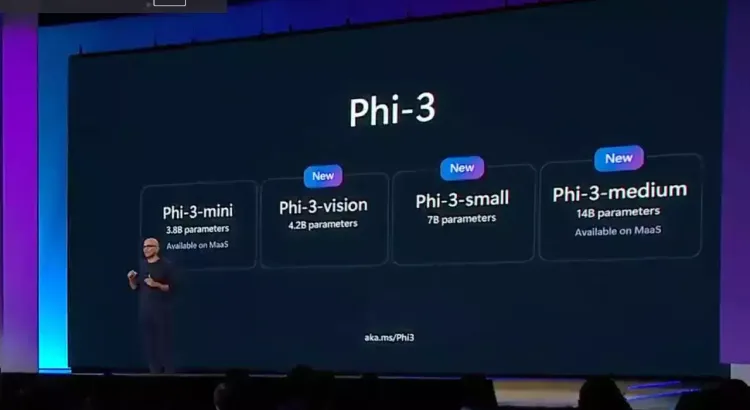

Microsoft ha desatado una oleada de innovación en Build 2024, presentando su nueva familia de modelos de lenguaje pequeño (SLM) que redefine la potencia de la IA. El protagonista de la jornada es Phi-3 Mini, un modelo ligero que sorprende por su capacidad, desafiando a titanes como GPT-3.5.

Pequeño pero feroz: Phi-3 Mini

A pesar de su tamaño compacto, Phi-3 Mini no se acobarda ante los desafíos. Entrenado con cuentos infantiles y utilizando un vocabulario sencillo, este modelo ha logrado alcanzar un rendimiento comparable al de GPT-3.5, todo ello ejecutándose en dispositivos móviles o PCs básicos.

Sus 3.800 millones de parámetros le permiten procesar lenguaje natural con fluidez, abriendo un abanico de posibilidades para aplicaciones en todo tipo de dispositivos. Phi-3 Mini ya está disponible en Azure para que desarrolladores exploren su potencial.

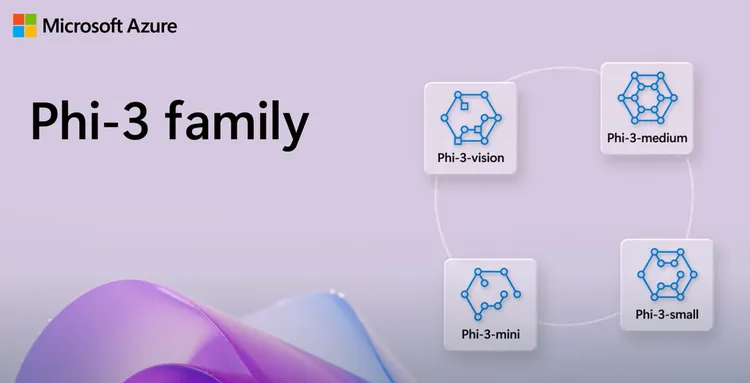

Inteligencia Artificial que ve y comprende: Phi-3 vision

Pero Microsoft no se detiene ahí. La compañía ha presentado Phi-3 vision, un modelo multimodal que integra la comprensión de texto e imágenes. Esta innovación permite a la IA razonar sobre gráficos, diagramas e incluso imágenes del mundo real, extrayendo información relevante y respondiendo preguntas de forma precisa.

A pesar de su complejidad, Phi-3 vision se mantiene compacto, con 4.200 millones de parámetros, superando en rendimiento a modelos más grandes como Gemini 1.0 Pro V o Claude-3 Haiku en tareas de razonamiento visual.

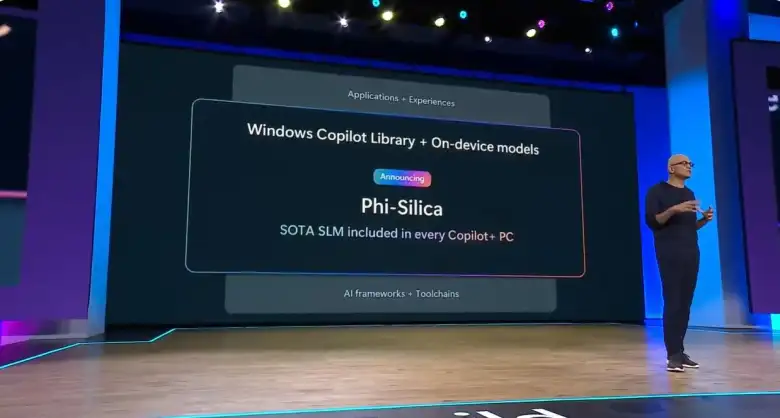

Software a medida para Copilot+ PC: Phi-Silica

Microsoft guarda lo mejor para el final: Phi-Silica, un SLM diseñado específicamente para los ordenadores Copilot+ PC. Integrado en dispositivos como Surface Pro y Surface Laptop, este modelo, con tan solo 3.300 millones de parámetros, aprovecha al máximo los chips Snapdragon X Elite de Qualcomm.

Esta IA se optimiza para ejecutarse en la NPU de Copilot+ PC, logrando inferencias locales ultrarrápidas y un bajo consumo energético.

Phi-Silica se convierte en el primer modelo de lenguaje implementado de forma local en Windows, con una latencia de primer token de 650 tokens/segundo y un consumo de energía de 1,5 vatios, Phi-Silica marca un hito en la eficiencia de la IA.

Los nuevos modelos de la familia Phi representan un salto gigante en cuanto a rendimiento, accesibilidad y eficiencia, acercando la IA a un público más amplio y abriendo un sinfín de posibilidades para el futuro.