Google presenta Gemma 2 2B, un modelo ligero y eficiente

Google acaba de presentar su último modelo de inteligencia artificial, Gemma 2 2B. Se trata de un modelo ligero que, según informes, ha superado a modelos más grandes como GPT-3.5 y Mistral 8x7B en importantes benchmarks.

Sin parar de innovar en IA

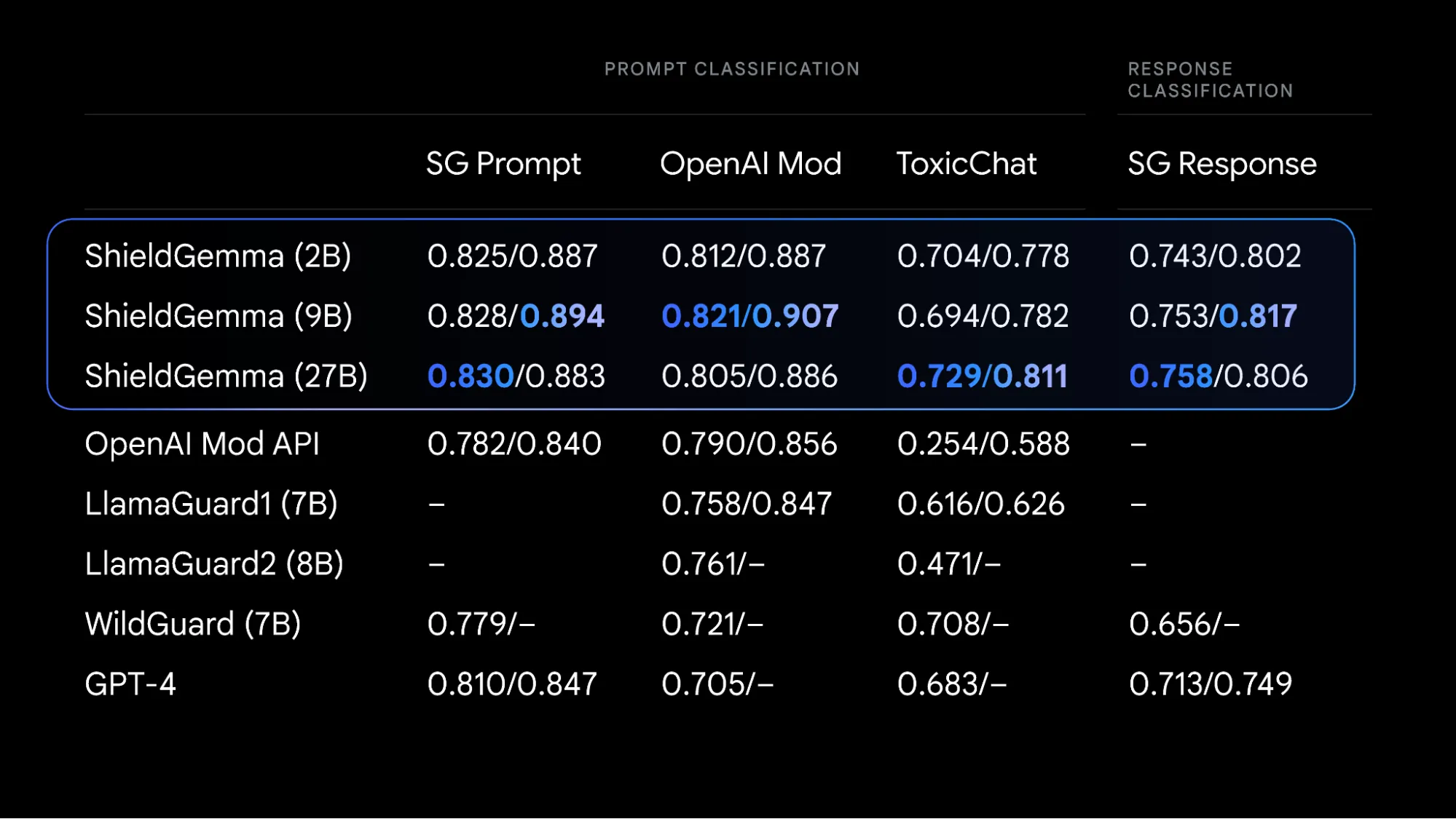

Apenas semanas después de lanzar los modelos de vanguardia Gemma 2, Google ha presentado Gemma 2 2B con avances de seguridad integrados. Junto con Gemma 2 2B, la compañía también ha anunciado nuevas herramientas: ShieldGemma y Gemma Scope.

“Con estas novedades, investigadores y desarrolladores pueden crear experiencias de usuario más seguras, obtener información sin precedentes sobre nuestros modelos e implementar de manera responsable una potente IA directamente en el dispositivo, desbloqueando nuevas posibilidades de innovación“, afirmó Google en su comunicado oficial.

¿Qué es Gemma 2 2B?

Según Google, Gemma 2 2B es un modelo ligero que obtiene resultados sorprendentes al aprender de modelos más grandes mediante destilación.

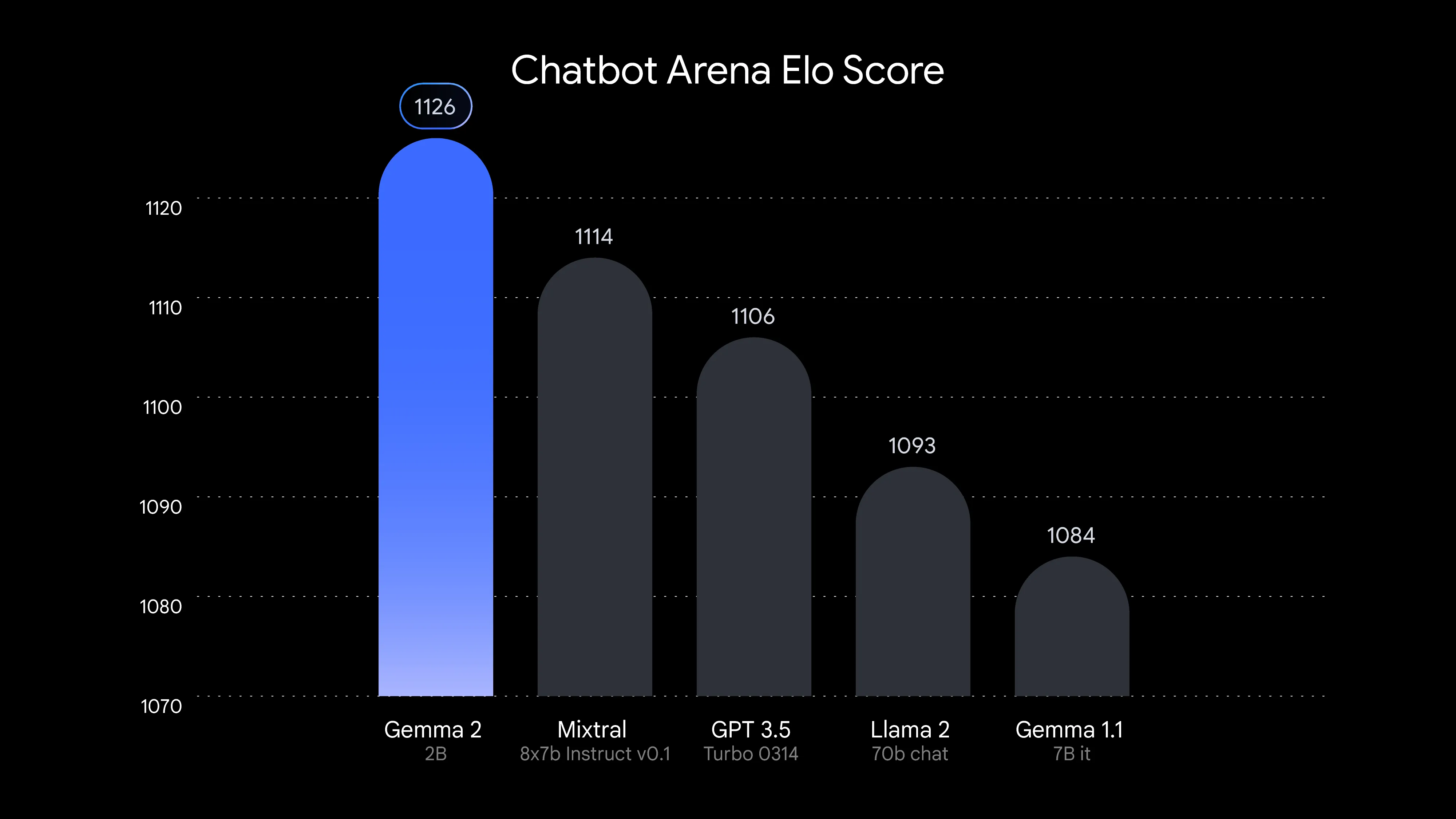

La compañía afirma que Gemma 2 2B supera a los modelos GPT-3.5 en Chatbot Arena, demostrando excepcionales capacidades de conversación artificial.

Google ha indicado que el nuevo modelo puede funcionar eficientemente en una amplia gama de hardware, sobre todo en portátiles hasta robustas implementaciones en la nube con Vertex AI y Google Kubernetes Engine (KGE).

El modelo también está optimizado con la biblioteca NVIDIA TensorRT-LLM para mejorar aún más su velocidad. Gemma 2 2B se integra perfectamente con Keras, JAX, Hugging Face, NVIDIA NeMo, Ollama y Gemma.cpp, y estará disponible pronto en la plataforma MediaPipe para facilitar el desarrollo. El modelo es abierto y accesible.

¿En qué se diferencia de otros modelos?

Gemma 2 2B cuenta con solo 2.6 mil millones de parámetros, pero fue entrenado con un enorme conjunto de datos de 2 billones de tokens. En Chatbot Arena, el modelo obtuvo una puntuación de 1130, igualando los resultados de GPT-3.5 Turbo y Mixtral – 8x7b, modelos significativamente más grandes que Gemma 2 2B.

En cuanto a MMLU (Massive Multitask Language Understanding), el modelo logró un puntaje de 56.1 y de 36.6 en MBPP (Mostly Basic Python Problems).

Con estos resultados, el nuevo modelo habría superado a su predecesor en más de un 10%. Dado que es de código abierto, los desarrolladores pueden descargar el modelo desde la página de Google.

Fuente: Google