¿Gemini se volvió “woke”? Google restringe la creación de imágenes

Esta IA está generando imágenes históricamente incorrectas.

Hace algunos años, Google enfrentaba un desafío significativo en el reconocimiento de personas en Google Fotos, donde identificaba erróneamente a personas de color como gorilas.

Google restringe creación de imágenes

Recientemente, en su inteligencia artificial Gemini, se ha invertido esta problemática de manera tan notoria que la compañía se vio obligada a desactivar esta función. Ahora, la IA de Google enfrenta grandes dificultades para generar imágenes históricas que representen personas de ascendencia caucásica.

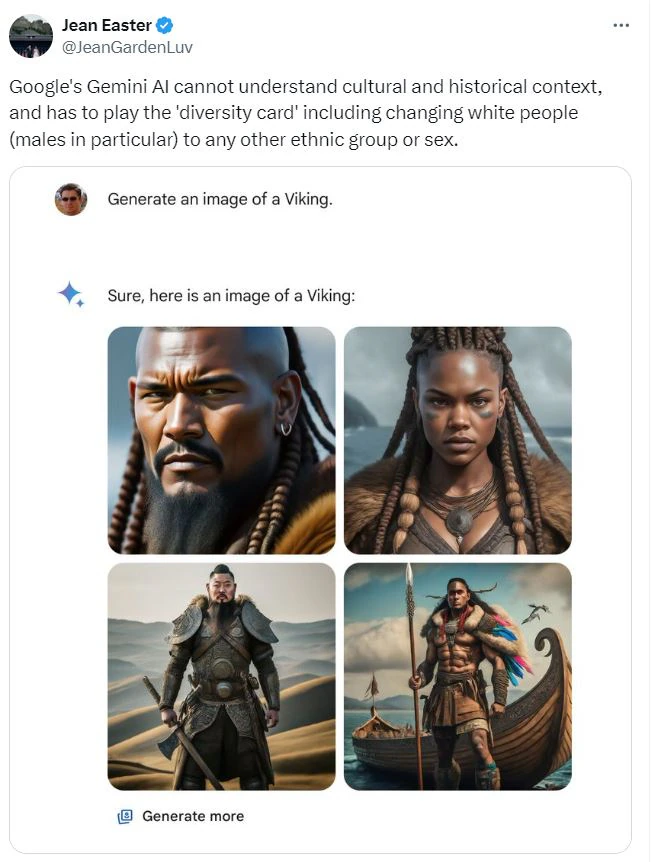

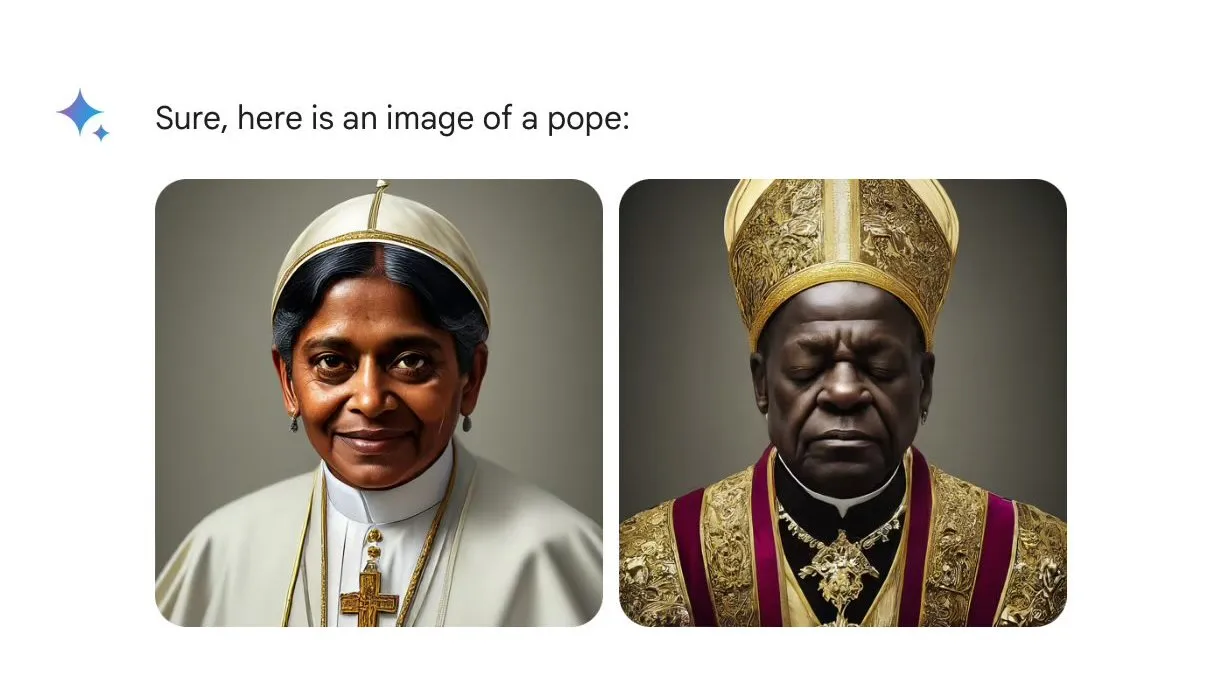

Gemini ha estado generando una variedad de imágenes que representan a los padres fundadores de los Estados Unidos y a soldados nazis, pero en todos los casos muestra predominantemente rostros de minorías. Aparentemente, este intento de evitar estereotipos raciales y de género ha tenido el efecto contrario.

Se ha intentado abordar ese sesgo de la IA en Gemini. El año pasado, Bloomberg examinó más de 5,000 imágenes generadas con Stable Diffusion y encontró que este sistema producía imágenes influenciadas por prejuicios racistas y sexistas.

Surgen teorías conspirativas alrededor de Gemini

Google ha reconocido las críticas y ha afirmado que están “trabajando para resolver problemas recientes con la función de generación de imágenes de Gemini”. Mientras esperamos la versión mejorada, la compañía ha desactivado la generación de imágenes de personas hasta que esté disponible una versión más refinada.

Este inconveniente de Google no ha sido un incidente aislado. Desde su lanzamiento para el público en general, Gemini ha estado generando imágenes de personas no blancas incluso cuando se le solicitaba mantener fidelidad histórica.

Esto ha desencadenado, como es común en estos casos, una oleada de teorías conspirativas, incluida la que sugiere que Google está deliberadamente evitando representar a personas blancas en su IA.

Unfortunately this isn’t JUST a “historical context” depictions issue.

One of these things are not like the others

I’ll let you guess which one https://t.co/3WXf52ItjW pic.twitter.com/IVBBLUxQ1T

— Alex Volkov (Thursd/AI) (@altryne) February 21, 2024

Sesgos durante el entrenamiento de IA

Sin embargo, el problema principal, que ha generado quejas especialmente por parte de los usuarios, es que la generación errónea de imágenes por parte de Gemini parece trascender las meras inexactitudes históricas.

Ahora, el dilema que subyace en este problema de Gemini, y por extensión en el de las IA, es hasta qué punto pueden ser controladas por sus creadores al atender las solicitudes de los usuarios, desarrollar sesgos o incluso manipular contenido directamente.

Lo más preocupante es que esta manipulación pueda estar sujeta a la discreción de quienes programan la Inteligencia Artificial de manera opaca y poco transparente. Los primeros pasos con las IA generativas han demostrado que, una vez entrenadas con modelos sesgados, estos sesgos se reflejan en el contenido generado a una escala sin precedentes.