Miles Brundage deja OpenAI y advierte sobre la falta de preparación para la Inteligencia Artificial General

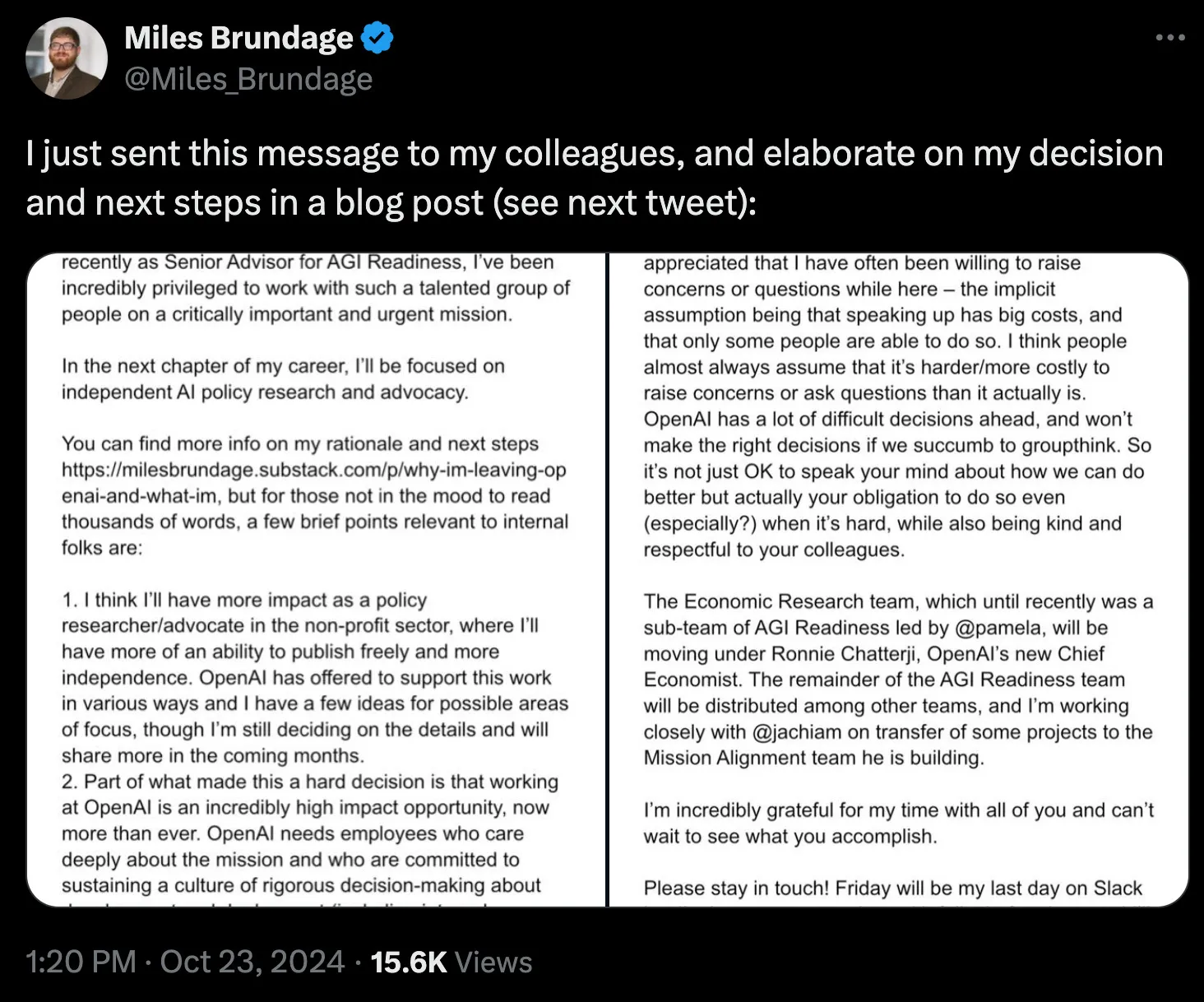

Miles Brundage, asesor senior de OpenAI sobre la preparación para la AGI (inteligencia artificial general, o IA a nivel humano), lanzó una advertencia contundente al anunciar su salida el pasado miércoles: nadie está preparado para la inteligencia artificial general, ni siquiera OpenAI.

“Ni OpenAI ni ningún otro laboratorio pionero está listo para la AGI, y el mundo tampoco lo está”, escribió Brundage, quien trabajó durante seis años en el desarrollo de las iniciativas de seguridad de la empresa.

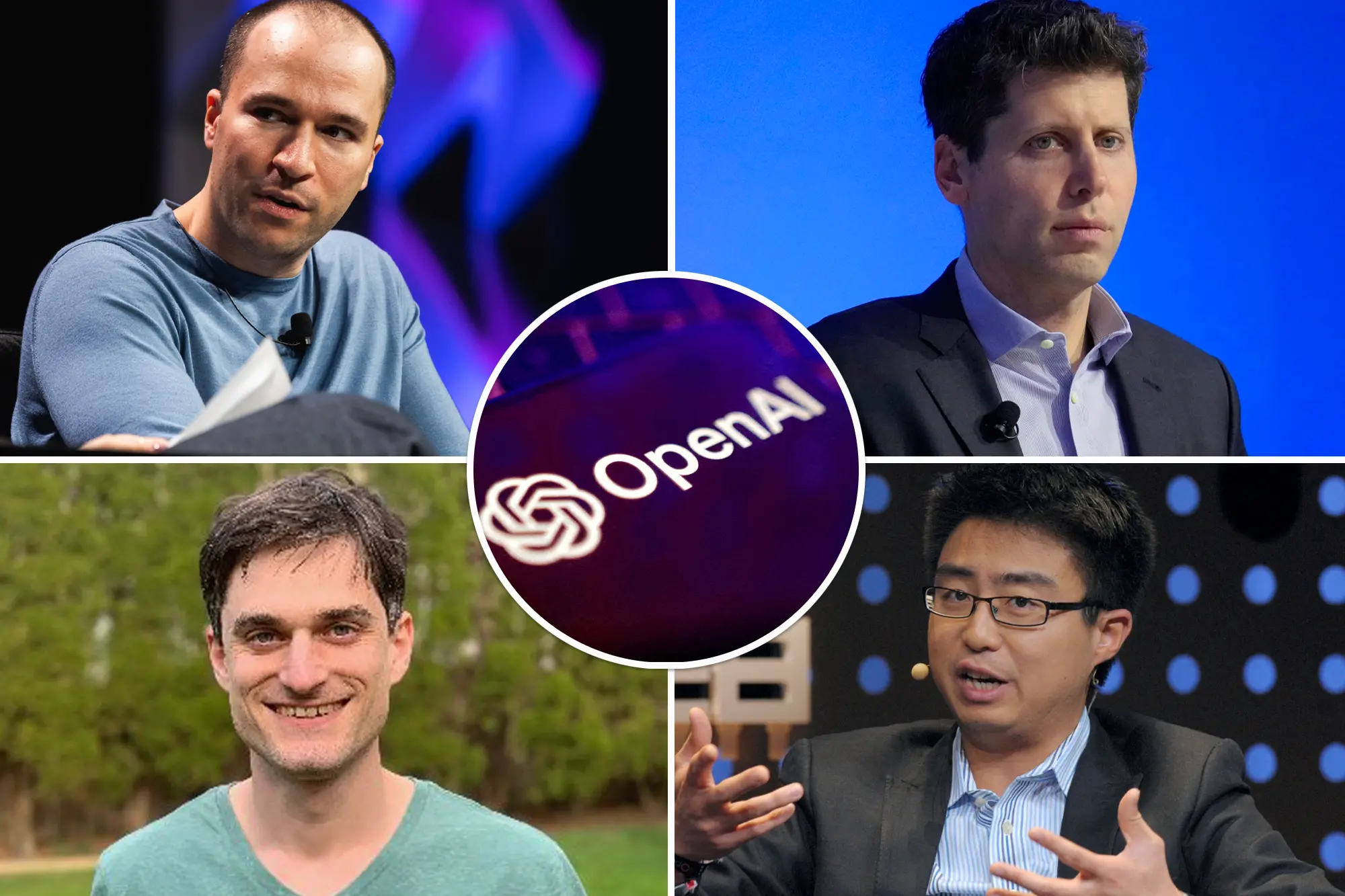

Continúan las salidas de altos perfiles de OpenAI

Su partida es la más reciente de una serie de salidas de alto perfil de los equipos de seguridad de OpenAI. Jan Leike, un reconocido investigador, también dejó la empresa después de afirmar que “la cultura y los procesos de seguridad han quedado relegados por productos más atractivos”.

Ilya Sutskever, cofundador de OpenAI, también abandonó la compañía para lanzar su propia startup enfocada en el desarrollo seguro de AGI.

La disolución del equipo de “Preparación para la AGI” de Brundage, que ocurre solo unos meses después de que OpenAI desmantelara su equipo de “Superalineación” dedicado a mitigar los riesgos a largo plazo de la IA, refleja tensiones crecientes entre la misión original de la empresa y sus ambiciones comerciales.

Una compañía que ha cambiado su enfoque

Se reporta que OpenAI enfrenta presiones para convertirse de una organización sin fines de lucro a una corporación de beneficio público con fines lucrativos en los próximos dos años, o de lo contrario podría verse obligada a devolver fondos de su reciente inversión de 6.6 mil millones de dólares.

Este enfoque hacia la comercialización ha preocupado a Brundage desde 2019, cuando OpenAI estableció su división con fines de lucro.

Al explicar su decisión de irse, Brundage mencionó las crecientes limitaciones en su libertad para investigar y publicar dentro de la empresa. Subrayó la importancia de contar con voces independientes en las discusiones sobre políticas de IA, libres de los sesgos y conflictos de interés de la industria.

¿Dejando a un lado la seguridad?

Esta salida también puede evidenciar una división cultural más profunda dentro de OpenAI. Muchos investigadores se unieron para avanzar en la investigación de IA, pero ahora se encuentran en un entorno cada vez más enfocado en productos.

La asignación de recursos internos ha generado tensiones; se informó que el equipo de Leike fue privado de acceso a potencia computacional para la investigación de seguridad antes de su eventual disolución.

A pesar de estos conflictos, Brundage señaló que OpenAI ha ofrecido apoyo para su trabajo futuro, incluyendo financiamiento, créditos API y acceso temprano a modelos, sin condiciones.

Fuente: X