NVIDIA presenta la Blackwell B200, la GPU definitiva para entrenamiento de IA

El chip de inteligencia artificial H100 de Nvidia lo convirtió en una empresa multinacional de varios billones de dólares, que podría valer más que Alphabet y Amazon, y los competidores han estado luchando por alcanzarlo.

Este es el verdadero poder e Nvidia

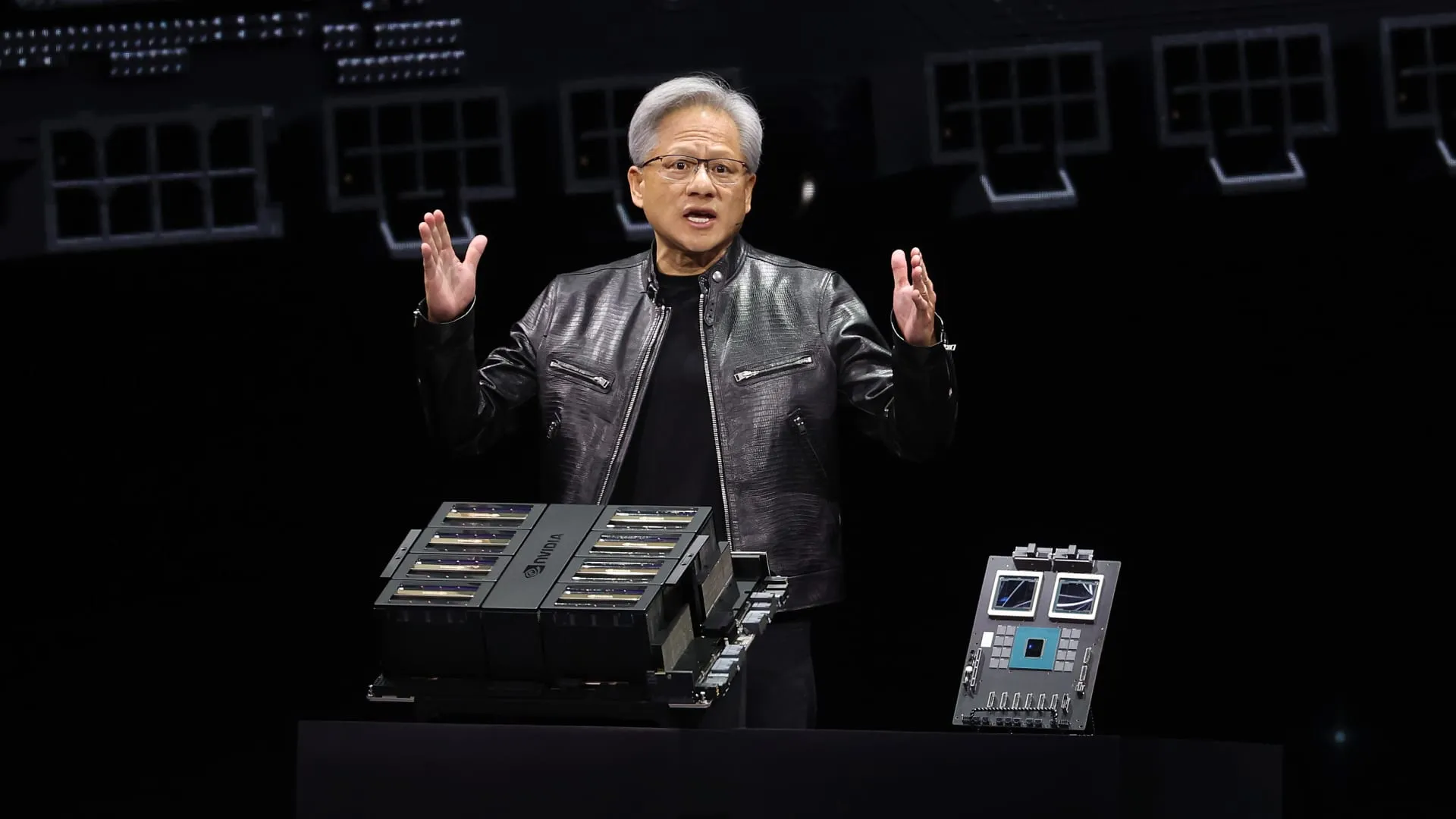

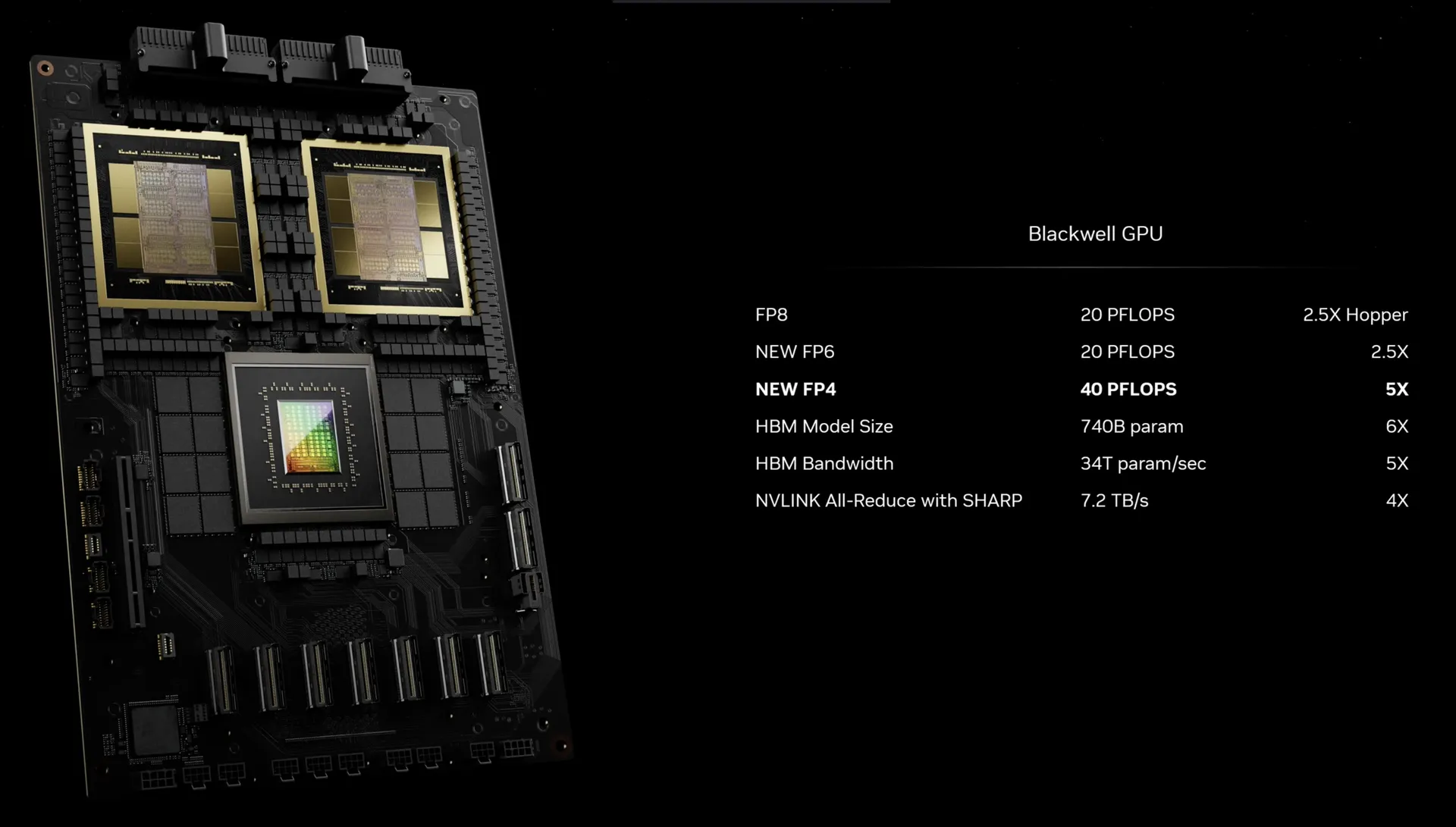

Pero quizás Nvidia esté a punto de ampliar su ventaja, con la nueva GPU Blackwell B200 y el “superchip” GB200. Nvidia afirma que la nueva GPU B200 ofrece hasta 20 petaflops de potencia FP4 a partir de sus 208 mil millones de transistores.

Además, señala que la GB200 que combina dos de esas GPU con una sola CPU Grace puede ofrecer 30 veces el rendimiento para cargas de trabajo de inferencia LLM, siendo considerablemente más eficiente. Nvidia dice que “reduce el costo y el consumo de energía hasta 25 veces” en comparación con un H100.

Según Nvidia, entrenar un modelo de 1,8 billones de parámetros habría requerido anteriormente 8.000 GPU Hopper y 15 megavatios de potencia. Hoy en día, el CEO de Nvidia afirma que 2.000 GPU Blackwell pueden hacerlo consumiendo solo cuatro megavatios.

Mejorando la eficiencia de entrenamiento de IA

En una prueba de referencia de GPT-3 con 175 mil millones de parámetros, Nvidia dice que el GB200 tiene un rendimiento algo más modesto, siete veces el rendimiento de un H100, y Nvidia afirma que ofrece cuatro veces la velocidad de entrenamiento.

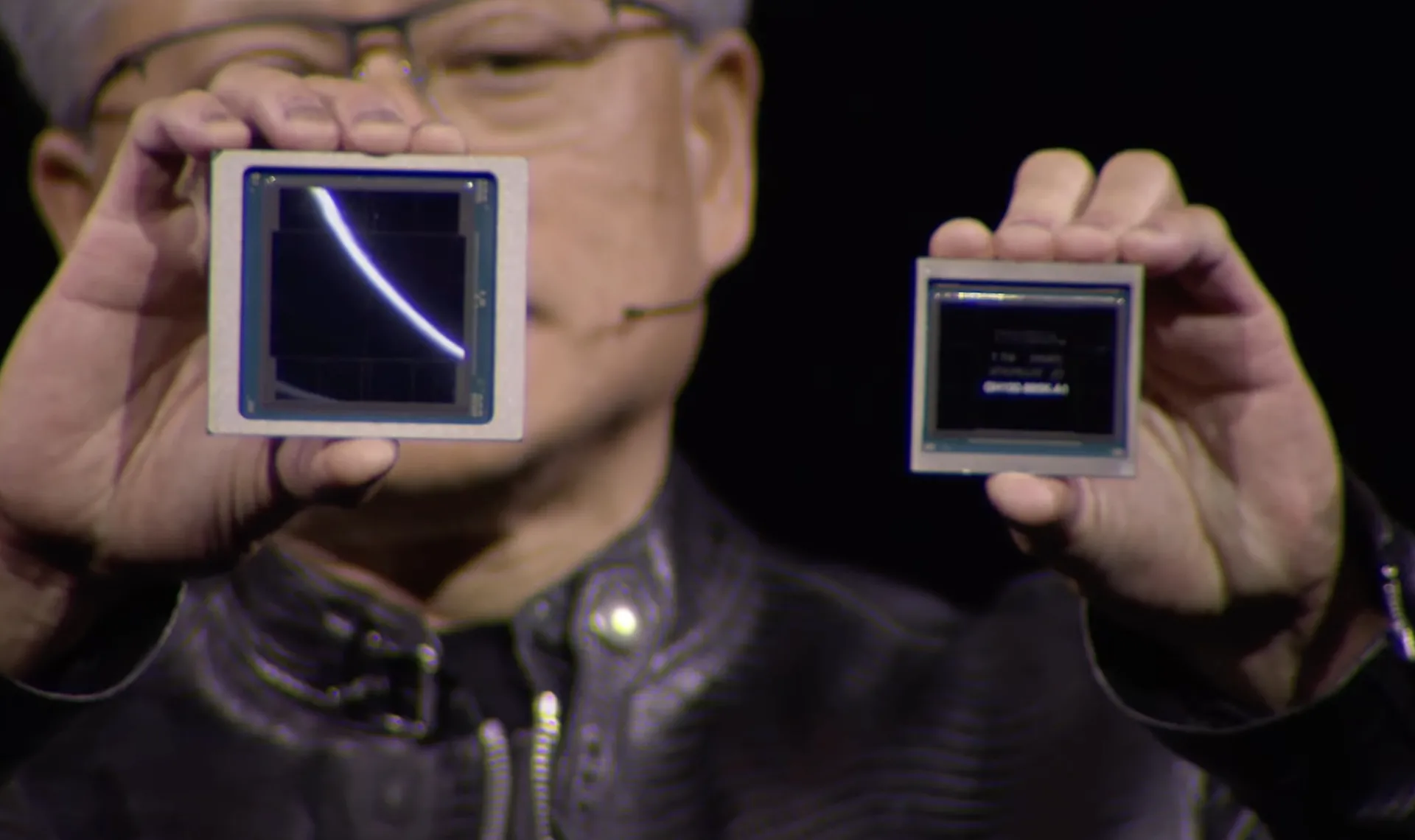

También han informado a los periodistas que una de las mejoras clave es un motor transformador de segunda generación que duplica el cálculo, el ancho de banda y el tamaño del modelo al utilizar cuatro bits para cada neurona en lugar de ocho (de ahí los 20 petaflops de FP4 que mencioné anteriormente).

Una segunda diferencia clave solo se produce cuando se conectan grandes cantidades de estas GPU, en este caso con un interruptor NVLink de nueva generación que permite que 576 GPU´s se comuniquen entre sí, con 1.8 terabytes por segundo de ancho de banda bidireccional.

Nvidia apunta a grandes compras de estas GPU

Esto requirió que Nvidia construyera un nuevo chip de interruptor de red completo, uno con 50 mil millones de transistores y algo de su propio cálculo a bordo: 3.6 teraflops de FP8, según Nvidia.

Anteriormente, un grupo de solo 16 GPU pasaría el 60 por ciento de su tiempo comunicándose entre sí y solo el 40 por ciento realmente computando.

Por supuesto, Nvidia cuenta con que las empresas compren grandes cantidades de estas GPU, y las está empaquetando en diseños más grandes, como el GB200 NVL72, que conecta 36 CPU y 72 GPU en un solo rack refrigerado por líquido para un total de 720 petaflops de rendimiento de entrenamiento de IA o 1,440 petaflops de inferencia.

Servicios de nube adquirirán esta tecnología

Cada bandeja en el rack contiene dos chips GB200 o dos interruptores NVLink, con 18 del primero y nueve del último por rack. En total, Nvidia dice que uno de estos racks puede soportar un modelo de 27 billones de parámetros. Se rumorea que el GPT-4 tiene alrededor de 1.7 billones de parámetros.

También se ha asegurado que Amazon, Google, Microsoft y Oracle ya están planeando ofrecer los racks NVL72 en sus servicios en la nube, aunque no está claro cuántos están comprando.